خانه متاورس ایران

خانه متاورس ایران

پژوهشگران حوزه هوش مصنوعی معماری تازهای معرفی کردهاند که توهمات متنی LLMها را تا ۴۰ درصد کاهش میدهد. این مدلهای خودتأییدگر با بهرهگیری از ساختار چندمنبعی و سیستم Fact-Verifier داخلی، صحت اطلاعات را پیش از تولید پاسخ بررسی میکنند و استاندارد تازهای برای AI Safety رقم میزنند.

در تازهترین موج نوآوریهای حوزهٔ هوش مصنوعی، پژوهشگران موفق شدهاند نسل جدیدی از مدلهای زبانی را معرفی کنند که توهمات متنی را تا ۳۰ تا ۴۰ درصد کاهش میدهند؛ دستاوردی که میتواند فصل تازهای از اعتمادپذیری در سیستمهای هوش مصنوعی رقم بزند. این کلاس جدید از مدلها که با عنوان Self-Verifying LLMs شناخته میشود، از معماریهای چندمرحلهای و درونی برای تأیید حقایق پیش از تولید پاسخ بهره میبرد.

در معماریهای کلاسیک LLM، مدل تنها بر اساس دادههای ورودی و احتمالات زبانی پاسخ تولید میکند؛ بدون آنکه صحت اطلاعات را بهصورت فعال بررسی کند. در مقابل، معماریهای خودتأییدگر از یک Fact-Verifier داخلی استفاده میکنند: مدلی کوچکتر و سریعتر که هر جمله، ادعا یا دادهی مهم را قبل از نهایی شدن پاسخ بررسی میکند.

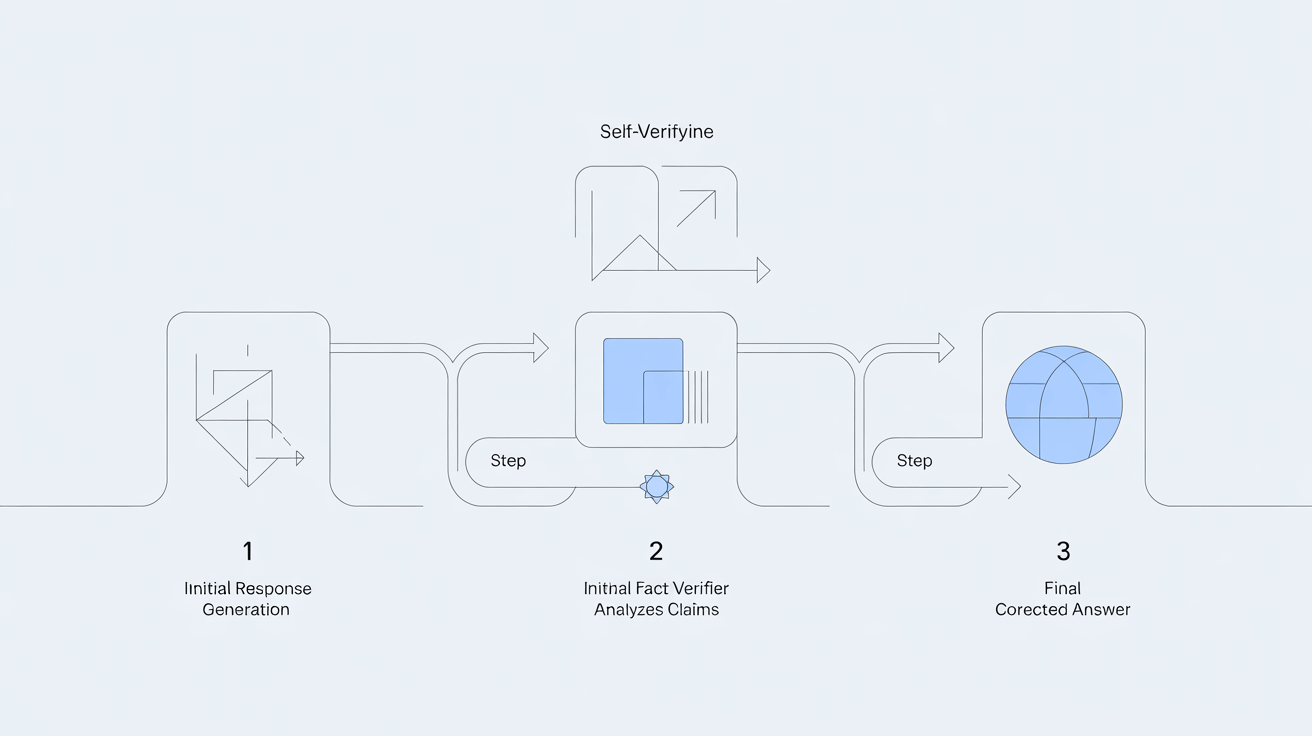

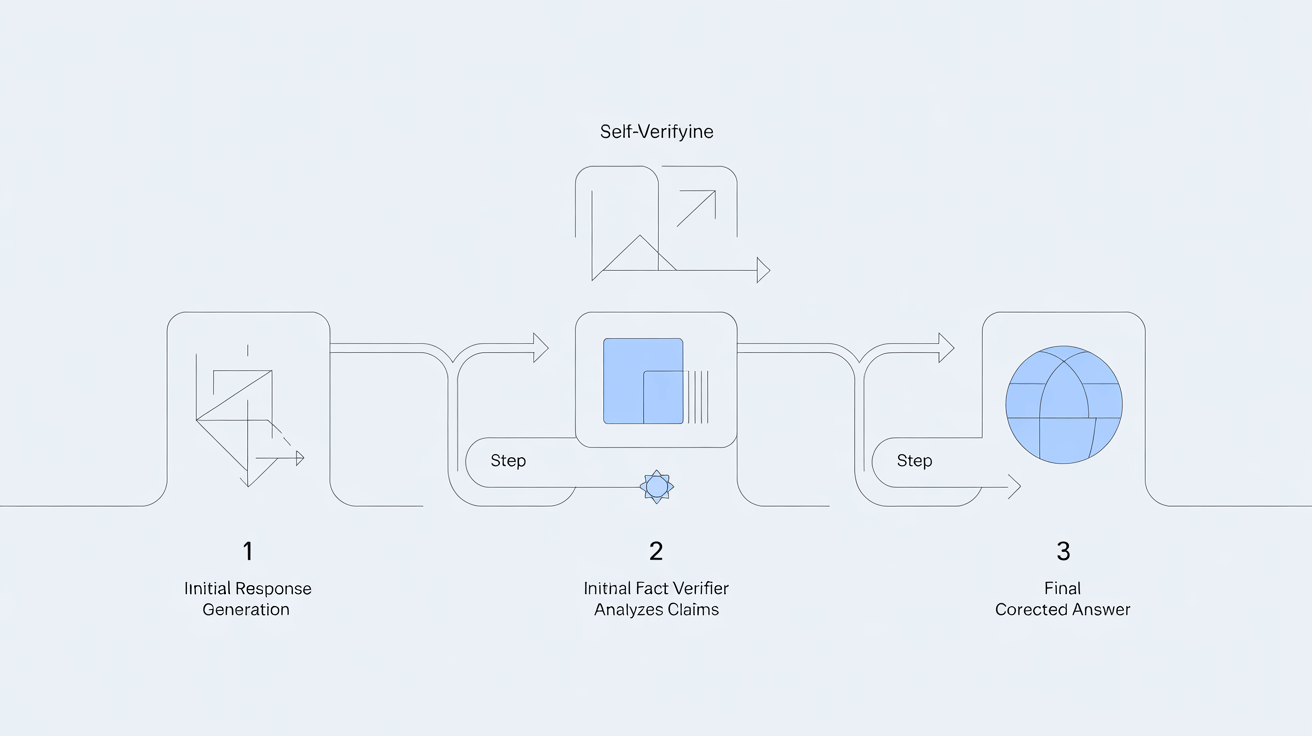

این ساختار معمولاً سه مرحله دارد:

تولید اولیه پاسخ توسط مدل اصلی

تحلیل و ارزیابی حقایق توسط ماژول Fact-Verifier

اصلاح و بازنویسی پاسخ نهایی بر اساس نتایج بررسی

این رویکرد باعث میشود مدل، ادعاهای بدون سند یا اطلاعات ساختگی را قبل از ظاهر شدن در خروجی حذف کند.

یکی از جذابترین ویژگیهای این معماری، استفاده از چند منبع مستقل برای تأیید اطلاعات است. مدل میتواند بهصورت همزمان:

نتایج جستجوی وب

پایگاههای دانش ساختاریافته

اسناد داخلی

و حتی مدلهای نسخهکوچکتر دیگری از خودش

را بررسی و با هم مقایسه کند.

نتیجه این روش، افزایش چشمگیر «ثبات» پاسخها و کاهش خطاهای رایج در موضوعاتی مانند تاریخ، سیاست، پزشکی و تحلیل داده است.

کاهش توهمات زبانی، یکی از مهمترین چالشهای AI Safety محسوب میشود. مدلهای جدید خودتأییدگر به دلیل ساختار لایهبهلایهی ارزیابی حقیقت، در کاربردهای حساس ــ مثل پزشکی، حقوق، تحلیل مالی، و اتوماسیون ــ امنیت و قابلیت اتکا را بهشکل محسوسی افزایش میدهند.

متخصصان معتقدند این معماری میتواند استاندارد جدیدی برای نسلهای بعدی LLM باشد؛ زیرا توانایی «تفکر کنترلشده» در کنار «تولید سریع» را ممکن میسازد.

با ادامه تحقیقات، انتظار میرود LLMها به سیستمهایی تبدیل شوند که درون خود فرآیندهای دائمی تأیید، مقایسه، بازبینی و استدلال را انجام دهند. به عبارت دیگر، هوش مصنوعی آینده تنها پاسخ نمیدهد؛ پیش از پاسخ، دلیل میآورد و حقیقت را میسنجد.

برای مطالعه مقالات بیشتر به سایت خانه متاورس ایران سر بزنید.